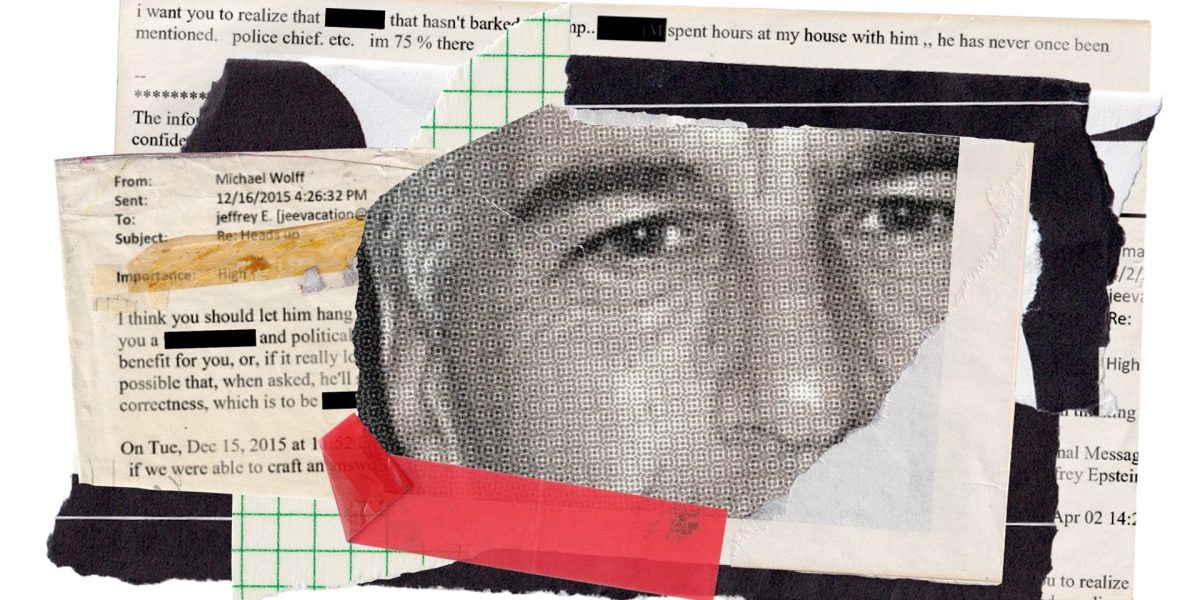

Un nou proiect online a stârnit recent presa și discuțiile publice referitoare la fenomeul Epstein, dar și la potențialul tehnologiei AI în investigarea unor cazuri complicate. Este vorba despre Jikipedia, o platformă creată de echipa din spatele serviciului de email Jmail, menit să organizeze într-un mod accesibil și enciclopedic volumul uriaș de date legate de Jeffrey Epstein și conexiunile sale. În timp ce inițial pare doar o încercare de a construi o bază de date mai clară pentru cercetare, realitatea indică faptul că această inițiativă are implicații mult mai complexe și delicate.

O repovestire digitală a cazului Epstein, dar cu riscuri evidente

Jikipedia funcționează ca o sursă de informații structurată, asemănătoare cu Wikipedia, dar bazată pe setul de date utilizat de ecosistemul Jmail. Fiecare pagină oferă detalii despre persoane, proprietăți, conexiuni de afaceri și relații personale, toate sintetizate automat de un sistem AI. În teorie, această metodă permite o explorare mai rapidă și comparativă a informației din arhivele complicate, fiind un instrument ce poate fi de ajutor jurnaliștilor sau cercetătorilor. Însă, în practică, ideea de a traduce mii de mesaje și date fragmentate în fișe concinse ridică probleme serioase legate de verificare și interpretare, mai ales în cazul unui subiect atât de sensibil.

Când vorbim despre o temă ca cea a lui Jeffrey Epstein, riscul de a face interpretări greșite sau de a amplifica prejudecăți fără intenție este uriaș. Cea mai mare problemă nu este neapărat erorile factuale, ci potențiala eroare de interpretare sau atribuirea unor acte fără suport factual clar, toate acestea putând avea consecințe grave pe plan legal și social. În plus, dacă o platformă funcționează precum o enciclopedie, utilizatorii pot ajunge să perceapă informația generată automat ca fiind verificată și definitivă, ceea ce poate duce la dezinformare sau confuzii.

Avantaje și impostura unei surse dinamică

Accesibilitatea crescută și comparabilitatea informației sunt avantajele principale. Pentru cercetători sau jurnaliști, un astfel de sistem simplifică procesul de orientare în labirintul datelor. În plus, standardizarea formatului asigură o anumită uniformitate, facilitând comparațiile și identificarea pattern-urilor interpersonale sau legale. Întrs-adevăr, aceste facilități pot ajuta la clarificarea unor aspecte și la creșterea transparenței în modul în care sunt prezentate informațiile. Dar, dacă utilizarea nu este critică, riscul cel mai mare rămâne acela al interpretării eronate, pentru că aceste date automate nu pot și nu trebuie să înlocuiască analiza umană și verificarea amănunțită.

Tocmai de aceea, în fața unei surse atât de dense și bine structurate, utilizatorii trebuie să păstreze o doză sănătoasă de scepticism. O pagină AI poate sugera conexiuni, dar nu și probitatea sau veridicitatea acestora în condițiile în care nu există o verificare riguroasă a sursei. În domenii atât de sensibile, orice confuzie poate avea impact grav, fie în conturarea opiniei publice, fie în construcția de cazuri legale.

Riscuri de interpretare și limitații etice

Avertismentul major vine din riscurile legate de prejudecăți și erori de context. O afirmație precum „X a fost menționat în N e-mailuri” poate fi interpretată greșit, iar o vizită într-o anumită locație devine cu ușurință un semnal de implicare penală, dacă informațiile sunt citate fără nuanță. În loc să clarifice, platforma poate încuraja concluzii pripite, în special dacă cele afișate sunt percepute ca fiind verificate și sumare.

De aceea, în abordarea acestor date, utilizatorii trebuie să trateze paginile generate de AI doar ca puncte de plecare. Situațiile complexe, mai ales cele juridice, necesită întotdeauna confirmări din surse primare, analiză critică și interpretare umană. Altminteri, riscăm ca o tehnologie menită să simplifice să devină un instrument de amplificare a incertitudinii și neîncrederii.

Ce ne arată evoluția aceasta despre viitorul investigațiilor digitale

Jikipedia, și similar tehnologiei, devine un test pentru un trend inandabil: trecerea de la arhive publice brute la narațiuni computerizate rapide. Într-o lume în care volumul de date crește exponențial, această tendință poate părea inevitabilă, dar vine cu un preț: pierderea nuanței, riscul de dezinformare și posibilitatea unor decizii greșite cauzate de interpretările automate.

Pentru presa și cercetarea serioasă, aceasta înseamnă o dublă responsabilitate: de a folosi AI-ul ca instrument în procesul de triere și explorare, dar și de a menține acțiunea umană în zona interpretării, verificării și contextualizării. Publicul trebuie să fie conștient că datele dintr-un astfel de sistem nu reprezintă adevărul absolut, ci doar o versiune sintetică, uneori incompletă sau incomplet verificată a realității.

Într-un domeniu atât de sensibil precum cel al investigațiilor legate de Epstein, aceste tehnologii pot deveni atât un aliat, cât și un factor de risc, dacă nu sunt gestionate cu responsabilitate. În mod clar, evoluțiile tehnologice de până acum arată că viitorul investigării digitale va fi tot mai mult alimentat de algoritmi, dar și tot mai mult de judecata umană critică.